Robots.txt là gì? Đây là câu hỏi mà nhiều người làm trong lĩnh vực SEO và thiết kế Website thường đặt ra để hiểu rõ hơn về cách thức hoạt động và vai trò của nó. Trong bài viết này, websitehcm.vn sẽ cùng bạn khám phá hướng dẫn viết Robots.txt, hiểu cách cấu hình Robots file, vai trò của nó trong việc quản lý truy cập bot và tối ưu SEO.

Xem thêm

Giới thiệu Robots.txt là gì?

Trong quá trình làm việc và phát triển website, chúng ta sẽ gặp nhiều vấn đề liên quan đến việc làm sao để kiểm soát sự truy cập của các bot từ các công cụ tìm kiếm. Các bot này có thể truy cập vào nội dung của website và thường xuyên quét để lập chỉ mục. Để quản lý hoạt động này, file Robots.txt ra đời. Vậy Robots.txt là gì?

Định nghĩa file Robots.txt

File Robots.txt là một file văn bản đơn giản, nằm ở thư mục gốc của website, dùng để cấu hình Robots file — xác định rõ phần nào của website được phép và phần nào chặn bot Google hoặc các công cụ tìm kiếm khác như Bing, Yahoo khi quét dữ liệu.

File này hoạt động dựa trên chuẩn giao tiếp giữa bot và webmaster, giúp quản trị viên có thể kiểm soát và quyết định về nội dung nào nên được đưa vào kết quả tìm kiếm để hiển thị.

Vai trò của file Robots

Vai trò của file Robots.txt trong quản trị website là rất lớn. Nó giúp quản trị viên bảo vệ quyền riêng tư cho các nội dung nhạy cảm, giảm tải cho máy chủ khi ngăn chặn các bot truy cập vào các thư mục không cần thiết. Hơn thế nữa, file này còn hỗ trợ việc tối ưu SEO bằng cách chỉ định chính xác các trang nào cần lập chỉ mục.

Cấu trúc và cách hoạt động của file Robots

Khi tìm hiểu Robots.txt là gì? bạn sẽ biết, file Robots.txt được cấu trúc theo một cú pháp đơn giản nhưng rất hiệu quả. Việc hiểu rõ về cấu trúc của file này sẽ giúp bạn thiết lập một cách chính xác hơn, nhằm kiểm soát được các bot truy cập vào website.

Cú pháp cơ bản trong Robots.txt

Cú pháp của file Robots.txt bao gồm các chỉ thị như User-agent, Disallow, Allow và Crawl-delay. Trong đó, “User-agent” được dùng để định danh bot mà bạn muốn điều chỉnh quyền truy cập, “Disallow” là chỉ thị để chặn bot không được truy cập vào thư mục hoặc trang nhất định

Trong khi “Allow” ngược lại, cho phép truy cập vào các nội dung cụ thể hơn so với “Disallow”. “Crawl-delay” cũng được sử dụng để chỉ định thời gian mà bot cần đợi trước khi tiếp tục quét.

Cách chỉ định bot thập dữ liệu

Để chỉ định bot nào được thu thập dữ liệu, bạn đơn giản chỉ cần thêm dòng lệnh “User-agent” vào file. Ví dụ, nếu bạn muốn chỉ định cho bot của Google (Googlebot) được phép truy cập vào toàn bộ website, bạn viết:

User-agent: Googlebot

Disallow:

Tuy nhiên, nếu bạn muốn chặn một bot của một công cụ tìm kiếm khác, bạn có thể thực hiện bằng cách sử dụng chỉ thị “Disallow”. Việc này giúp chặn bot Google hoặc các bot không mong muốn, đồng thời giảm tải cho máy chủ khi bị quét liên tục. Bạn có thể tinh chỉnh các quy tắc để cho phép index thư mục mong muốn mà không làm ảnh hưởng đến phần còn lại của website.

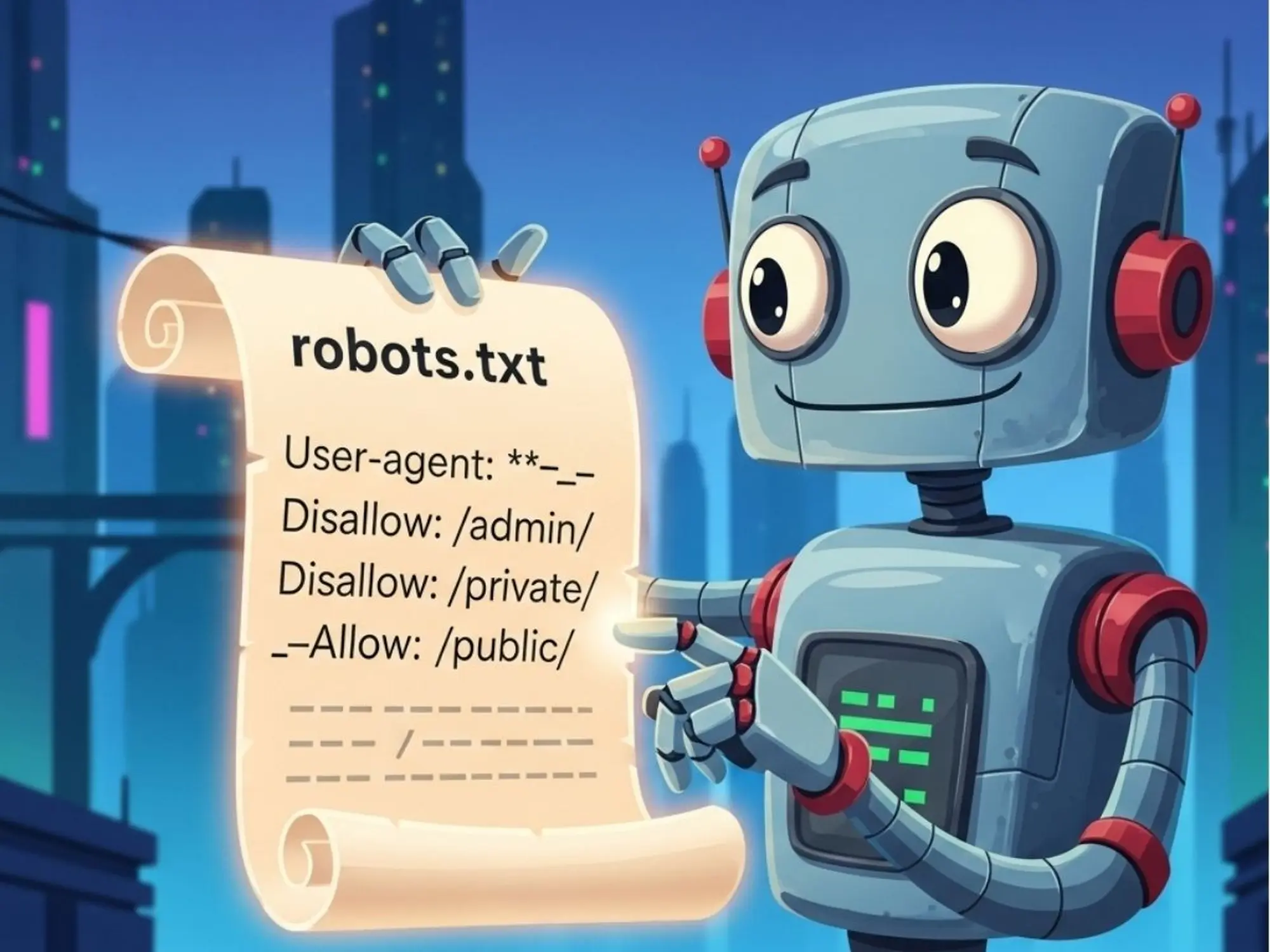

Ví dụ minh họa

Một ví dụ thực tế về file Robots.txt có thể như sau. Trong ví dụ này, tất cả các bot sẽ bị chặn truy cập vào thư mục “admin” và “private”, nhưng vẫn được phép truy cập thư mục “public”. Điều này giúp bạn bảo vệ thông tin nhạy cảm trong khi vẫn cho phép index thư mục quan trọng, đảm bảo các trang cần SEO vẫn được lập chỉ mục chính xác.

User-agent: *

Disallow: /admin/

Disallow: /private/

Allow: /public/

Tác dụng của Robots.txt trong việc chặn bot

Khi tìm hiểu Robots.txt là gì, bạn sẽ thấy đây không chỉ là công cụ mạnh mẽ trong việc quản lý bot, mà còn là nền tảng để cấu hình Robots file chính xác — giúp chặn bot Google ở những khu vực không mong muốn và cho phép index thư mục cần thiết.

Chặn bot truy cập vào thư mục

Một trong những tác dụng chính của file Robots.txt là khả năng chặn các bot truy cập vào những thư mục mà bạn không muốn công khai. Điều này đặc biệt quan trọng đối với những nội dung không phục vụ cho mục đích SEO hoặc những trang quản trị mà bạn không mong muốn người ngoài truy cập.

Ngăn chặn index nội dung trùng lặp

Nội dung trùng lặp là một vấn đề lớn trong SEO, có thể làm giảm thứ hạng trang của bạn trên kết quả tìm kiếm. Sử dụng file Robots.txt để chặn các bot truy cập vào những trang có nội dung trùng lặp sẽ giúp bảo vệ website của bạn khỏi những ảnh hưởng tiêu cực.

Bạn có thể kết hợp với các chỉ thị khác như canonical để hướng dẫn bot đến nội dung gốc. Thẻ canonical là một công cụ quan trọng trong SEO, giúp bạn chỉ định URL chuẩn mà bot tìm kiếm nên ưu tiên lập chỉ mục.

Bảo vệ dữ liệu nhạy cảm

Nhiều website chứa dữ liệu nhạy cảm như thông tin tài khoản, thông tin giao dịch hoặc các dữ liệu riêng tư. File Robots.txt có thể được sử dụng để ngăn chặn các bot truy cập vào các thư mục chứa những thông tin quan trọng này, giúp bạn tăng cường bảo mật cho website.

Kết luận : Qua hướng dẫn viết Robots.txt và cách cấu hình Robots file chuẩn SEO, bạn có thể dễ dàng kiểm soát hoạt động của bot, chặn bot Google tại khu vực nhạy cảm, và cho phép index thư mục cần thiết để cải thiện thứ hạng tìm kiếm. Qua đó, chúng ta nhận thấy rằng việc sử dụng file Robots.txt không chỉ giúp bảo vệ nội dung của website mà còn hỗ trợ tích cực cho công tác tối ưu hóa SEO.